15.2 Что делать, если сайт не индексируется.

Сайт не индексируется. Что делать?

Я много писал, что хороший сайт не столкнется с проблемами индексации, и тем не менее именно мой Крым-Блог

, которым я иллюстрирую все примеры в этом учебнике, очень долго не хотел индексироваться Гуглом. Так что вопрос из заголовка я плотно изучил на практике.

Крым-Блог создан на CMS Joomla, под управлением которой работают миллионы ресурсов. Никаких наворотов, уникальные тексты, хорошие ссылки – все условия для идеальной индексации. И несмотря на это Гугл первые два месяца добавлял к себе по одной страничке в три дня.

При этом парадоксально: позиции и трафик с гугла уже имелись, а в индексе сидело всего 3-5 страниц. Логика разбивается на мелкие кусочки, но факт – так оно и было.

Итак, что нужно предпринять, если сайт не индексируется? Первым делом не паниковать. Изучая форумы с подобными вопросами, я увидел что проблема более чем решаема. Чем хороши форумы – читаешь крик о помощи годичной давности «сайт не индексируется уже 3 месяца!». Заходишь в поиск и проверяешь индексацию указанного ресурса. И видишь – все уже в порядке, значит вебмастер решил проблемы. И так было практически во всех случаях, что несомненно внушает оптимизм.

1. Публикация ссылки на очень посещаемом сайте . Работает безотказно, опубликованная страница влетает в индекс через пару часов после публикации. Недостаток – очень дорого, а гарантированно индексируется только та самая ссылка, которую мы разместили.

Индексацию остальных страниц это может подтолкнуть, а может и нет.

Недостатки те же – если аккаунты хорошие, то публикация в них стоит денег. Но все же это обойдется ощутимо дешевле первого способа.

3. Прогон по соц. закладкам . Сам не пробовал, но говорят, что для ускорения индексации это тоже работает хорошо.

Преимущества – дешево. Недостатки – соц. закладки заспамлены просто безумно, не очень мне нравится публиковать свой ресрус в таком окружении. Хотя вреда от этого быть не должно.

4. Посмотреть как ГуглБот . Отличный способ для гугла. Идем в панель вебмастеров, раздел Сканирование ->Посмотреть как Google bot. И там можно отправить запрос на принудительную индексацию выбранной страницы. Не пройдет и суток, как страница практически гарантированно появится в индексе.

Тут правда есть ограничение – за раз отправить боле 10 страниц не получится. Правда это число «возобновляемое». Т.е. использовали вы весь лимит на отправку в индекс, а через недельку эта возможность снова становится доступной.

При нажатии на кнопку «отправить в индекс» есть выбор между «отправить данную страницу» и «отправить данную страницу и все с ней связанные». Во втором случае мы просим гугл проиндексировать не только заданный УРЛ, но и пройти по ссылкам с него на другие разделы сайта.

По моему опыту, индексация отправленной страницы происходит всегда, а вот по ссылкам на ней Гугл может и не пойти.

5. Xml карта сайта . Карты сайта изначально появились в далеком прошлом. Их цель была упростить навигацию на сайте. Карта обычно содержала структурированную информацию о разделах ресурса и позволяла быстро на них перейти.

Для поисковиков карта сайта тоже благо, т.к. ссылки на все страницы собраны в одном месте.

По моим соображениям, эта возможность является мега-полезной для сайтов с десятками тысяч страниц. Если же у вас их всего пара сотен, то xml картой сайта можно не заморачиваться.

Но судя по отзывам, добавление карты сайта позволяет ускорить индексацию. Мой личный опыт этого не подтверждает, но хуже от добавления xml карты точно не станет.

Ну и заключительный совет повторю еще раз – не спешите, рано или поздно поисковые системы обязательно проиндексируют ваш ресурс.

Моя книга издана в бумажном варианте.

Если этот учебник оказался для вас полезным - то вы можете отблагодарить меня не только морально, но и вполне осязаемо.

Для этого нужно перейти на

От автора: вы пишете полезный и интересный контент. А может быть неполезный и неинтересный – это ваше дело. Но почему сайт не индексируется в яндексе на протяжении долгого времени? Давайте рассмотрим все основные причина.

Посмотрите на эту картинку. Да наверняка вы ее уже не раз видели. Действительно в яндексе может найтись все. Но то, что не проиндексировано, никогда не найдется, потому что поисковик просто не знает о нем. А раз так, то вопрос индексации является очень важным для любого веб-мастера, владельца сайта и оптимизатора. Сегодня я напишу как минимум о нескольких причинах, почему у вас могут быть проблемы с индексацией.

Первая и наиболее вероятная причина – возраст сайта

Дело в том, что большинство веб-мастеров, которых заботит вопрос быстрой индексации – владельцы молодых сайтов. Я уверен в этом потому, что сам развивал два сайта с нуля с первых же дней их существования. Нужно понимать, что Яндекс относится к только что вылупившимся на свет сайтам с недоверием, и в этом его нельзя упрекнуть – уж больно много появилось ГС.

Итак, чем моложе ваш сайт, тем меньше шанс быстрой индексации страниц сайта. Как правило, более менее быстро можно загнать в индекс главную страницу, так как у нее наивысший приоритет, а вот остальные в любом случае не так быстро попадут в индекс.

Если вы хотите проиндексировать хотя бы главную страницу, добавьте сайт в Яндекс.Вебмастер, если вы еще не сделали этого. Также добавьте url проекта в addurl (Сообщить о новом сайте). После подтверждения прав на сайт я также рекомендую сразу сделать следующее:

Загрузить в вебмастер xml-карту сайта (это непосредственно может улучшить индексацию, так как поисковый робот будут лучше осведомлен о всех имеющихся страницах).

Загрузить и проверить файл robots.txt. Его можно проверить на ошибки.

Настроить главное зеркало сайта, чтобы не возникло дублей с www и без него

Это то, что прямым или косвенным образом повлияет на скорость индексации. Если вы сделали все это, вам остается только ждать индексации, добавляя все новые url-адреса проекта с помощью того же addurl.

Хорошо, возможно, вы все это сделали и все равно не можете дождаться индексации. Неужели никак нельзя ускорить процесс? Тут нужно понимать, что многое от вас самих не зависит. Яндекс по умолчанию индексирует намного медленнее, чем Google. Тем более молодые сайты. Обычно в течение 1-3 недель новые страницы молодых сайтов появляются в индексе. Считайте этот временной отрезок вполне нормальным.

Я лишь хочу донести до вас, что если причина медленной индексации в возрасте сайта, то не стоит особо беспокоиться. Со временем ваш проект вырастет и из младенца превратится в рядовой интернет-ресурс, хорошо известный поисковикам. Тогда и настанет время, когда новые материалы будут влетать в индекс быстро, в течении нескольких дней.

Такую ситуацию я заметил на двух молодых сайтах, которые продвигал. Когда возраст сайта перевалил за 6 месяцев, скорость входа новой статьи в индекс увеличилась. По заявлениям самого яндекса, максимально долгий срок индексации – 2 недели. Если они прошли и в индексе ничего нет, значит, могут быть другие проблемы или ошибки. Конечно, 2 недели не стоит ждать, а лучше все проверить как только сможете. Далее я рассмотрю наиболее частые ошибки и факторы, из-за которых сайт или отдельные его страницы могут не попасть в индекс.

Запрет на индексирование в robots.txt

Это важный и полезный файл, но в нем могут быть ошибки, если вы прописывали инструкции сами, либо взяли на первом попавшемся сайте. Самое главное, чтобы не было такой команды: Disallow: /

Также проверьте, какие конкретные команды даются для бота Яндекса (user-agent: Yandex). Едва ли проблема именно в этом файле, но глупо будет его не проверить.

Использование мета-тега robots

К слову, в самом robots.txt вы можете не найти никаких опасных команд, которые закрывали бы обход к сайту и его конкретной странице. Но ведь помимо этого есть еще мета-тег robots, с помощью которого можно закрыть конкретную страницу от индексации, а также ссылки на ней.

< meta name = ”robots ”content = ”noindex , nofollow ”> |

Например, такой кусок кода явно свидетельствует о том, что страница будет закрыта. Проверьте, нет ли его у вас где-нибудь в шапке. Если вы хотите закрыть все ссылки, но открыть текст (тогда страница будет проиндексирована), используйте параметры index, nofollow, а если нужно открыть все – index, follow.

Запрет на индексирование в настройках движка

Насколько я помню, перед установкой wordpress можно отметить галочкой опцию, чтобы не индексировать сайт в поисковых системах. Это может быть полезно первое время на молодых сайтах, которые находятся в разработке, чтобы всякие тестовые страницы не попадали в индекс. Возможно, вы установили эту галочку случайно во время установки или позже из настроек. В таком случае просто снимите ее.

Неправильное использование тега noindex

Тег noindex – полезный, но опасный тег при его неправильном использовании. Он позволяет закрыть текст от индексации. То есть текст, помещенный в него, восприниматься поисковиком не будет. Соответственно, если вы случайно обернете всю статью в noindex, она не проиндексируется, так как нечего индексировать (все закрыто).

Едва ли вы можете допустить такую ошибку, но тег закрасться в сами файлы шаблона. Возможно, он у вас где-нибудь в header.php открывается, а потом нигде не закрывается. Получается забавная ситуация, что все закрыто. Иными словами, проверьте код своего сайта. На самом деле необязательно быть программистом и верстальщиком для этого.

Вы можете использовать программу вроде Архивариус для быстрого поиска по многим файлам (введите noindex), либо воспользоваться стандартным поиском по файлу. Также может помочь отладчик (F12 в Google Chrome), но это уже больше для разработчиков. Дополнительно вы можете проверить каждую конкретную страницу. Не случилось ли такого, что с помощью noindex вы хотели закрыть какой-то неуникальный фрагмент текста, но не закрыли тег в нужном месте?

Фильтры от поисковых систем

В данном случае нас интересуют фильтры от Яндекса. Хотя вы должны понимать, что они есть и у Google и они же могут быть причиной того, что ваш сайт и в этом поисковике не попадает в индекс.

В частности, у всех молодых сайтов есть фильтр песочница (sand-box). Это не проблема, это нормально. Как маленькие детки играют в песочнице, так молодые и зеленые интернет-проекты тоже туда попадают. Нет, обходить весь город в поисках своего сайта не нужно, просто знайте, что скорость индексации у молодых сайтов ниже. Об этом я уже говорил выше.

Но песочница – это временная мера поисковика. И вообще это не страшный фильтр, потому что он накладывается на всех. Другое дело, это санкции за использование недобросовестных приемов при продвижении сайта. Чаще всего это скрытый или явный спам ключевыми словами в тексте, а также в мета тегах. Иными словами, играйте по правилам поисковых систем, и подобных проблем у вас не возникнет.

Плохая история домена

Этот пункт актуален для тех, кто купил домен и начал на нем развитие своего нового проекта, либо для тех, кто зарегистрировал покинутый прежним владельцем домен.

Конечно, перед покупкой любого домена я рекомендую вам проанализировать его. Частично это можно сделать с помощью таких сервисов, как ВебАрхив (снимки сайта) и linkpad.ru (анализ ссылочной массы). По снимкам вы можете определить, какой тематики был сайт и что за контент на нем был. По ссылочной массе можно также примерно понять тематику. Проверяйте также домен на наличие у него фильтров поисковых систем.

В общем, такой небольшой анализ убережет вас от покупки домена с плохой историей. Если вы все же приобрели такой, возможно, с помощью запросов в тех. поддержку со временем репутацию удастся восстановить. Но лучше уже начинать с нуля, чем так.

Язык сайта

Вы должны понимать, что в первую очередь Яндекс ориентирован на страны СНГ. Если вы хотите, чтобы индексировались страницы английских, немецких и другие иностранных сайтов, то это вполне возможно, но только при условии качественного контента. Для иностранных сайтов есть Google и много других поисковиков, так что в первую очередь вам туда.

Процент уникальности ваших текстов

Есть еще одна веская причина, почему ваш сайт может не индексироваться Яндексом. Эта причина – неуникальный контент. Например, скопировали вы текст с другого источника и вставили себе, никак не изменив. Практика показывает, что Яндекс может вообще не проиндексировать полностью неуникальный контент и может долго не обращать внимание на страницы, уникальность которых менее 50%. Лучше иметь уникальность от 90%.

Чтобы лучше понимать, почему у неуникального контента гораздо меньше шансов на успешную индексацию, вы должны примерно понимать алгоритм, по которому новые страницы попадают в индекс. В частности, перед попаданием роботом проводится некий анализ контента и если он оказывается низкого качества, страница просто может не попасть в индекс. Чтобы она все-таки попала, необходимо улучшить качество текста.

Ошибки сервера

Это последняя причина, которую мы рассмотрим. Она чисто технического характера. В частности, одним из показателей качества и надежности вашего ресурса является то, что он постоянно доступен в сети 24 часа в сутки, каждый день. Конечно, мелкие сбои могут быть и это нормально. Но когда ваш сайт выключается на несколько часов (или, еще хуже, дней), то поисковый робот, придя на новые страницы, просто не сможет их открыть и вынужден будет уйти.

Таким образом, могут даже выпасть из индекса те страницы, которые уже там были. Как не допустить всего этого? Прежде всего, выбирать хорошего хостера и более менее нормальный тариф. Экономить на своем сайте не стоит. Лучше платите 300-500 рублей в месяц, чем 50.

Также если вы покупаете тарифы VPS/VDS, то вам, скорее всего, придется самостоятельно настраивать сервер. В частности, выбирать OC виртуальной машины, ставить какие-нибудь утилиты и т.д. Если вы вообще полный ноль в серверной настройке, лучше пока не покупать VDS или выбирать тариф, где вам гарантируется тех. поддержка от провайдера.

В частности, к серверным ошибкам относятся все с кодом 4**, 5** (трехзначные с четверкой и пятеркой в начале). Например, из-за отсутствия оптимизации работы баз данных может возникать ошибка. Особенно, если по сайту гуляют десятки и сотни людей, а ресурсов у вас немного.

Итог

Что ж, мы рассмотрели все основные причины. Теперь вы знаете что делать, когда сайт не индексируется в Яндексе. Если вами проверено абсолютно все и не найдено никаких ошибок и проблем, значит, нужно просто ждать. Как я уже говорил, Яндекс индексирует не так быстро, как Google. Скорость захода в индекс колеблется от 1 дня до 3 недель.

Ну а другие фишки не только по индексации, но и в общем по продвижению и раскрутке блога, вы можете найти в . Поверьте, этих фишек достаточно много, так что уже завтра (если вдруг начнете изучать курс) вы будете в шоке от того, как много вещей вы не знали!

Но знание спасает нас от неприятностей при продвижении сайта. А раз так, читайтe Webformyself, подписывайтесь на нас там, где вам удобно, и до скорых встреч!

Что такое индексирование? Это процесс получения роботом содержимого страниц вашего сайта и включение этого содержимого в результаты поиска. Если обратиться к цифрам, то в базе индексирующего робота содержится триллионы адресов страниц сайта. Ежедневно робот запрашивает миллиарды таких адресов.

Но этот весь большой процесс индексирования Интернета можно разделить на небольшие этапы:

Во-первых, индексирующий робот должен узнать о появлении страницы вашего сайта. Например, проиндексировав другие страницы в Интернете, найдя ссылки, либо загрузив файл set nemp. О страничке мы узнали, после чего планируем обход этой страницы, отправляем данные к вашему серверу на запрос этой страницы сайта, получаем контент и включаем его в результаты поиска.

Этот весь процесс – это процесс обмена индексирующим роботом с вашим сайтом. Если запросы, которые посылает индексирующий робот, практически не меняются, а меняется только адрес страницы, то ответ вашего сервера на запрос страницы роботом зависит от многих факторов:

- от настроек вашей CMS;

- от настроек хостинг провайдера;

- от работы промежуточного провайдера.

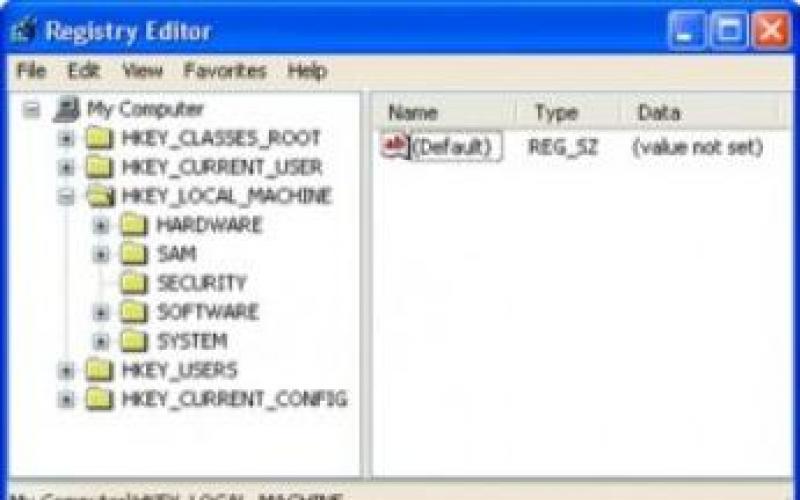

Этот ответ как раз меняется. Прежде всего при запросе страницы робот от вашего сайта получает такой служебный ответ:

Это HTTP заголовки. В них содержится различная служебная информация, которая дает роботу понять передача какого контента сейчас будет происходить.

Мне хочется остановиться на первом заголовке – это HTTP-код ответа, который указывает индексирующему роботу на статус страницы, которую запросил робот.

Таких статусов HTTP-кодов несколько десятков:

Я расскажу о самых популярных. Наиболее распространенный код ответа – это HTTP-200. Страница доступна, ее можно индексировать, включать в результаты поиска, все отлично.

Противоположность этого статуса – это HTTP-404. Страница отсутствует на сайте, индексировать нечего, включать в поиск тоже нечего. При смене структуры сайтов и смене адресов внутренних страниц мы советуем настраивать 301 сервер на редирект. Как раз он укажет роботу на то, что старая страница переехала на новый адрес и необходимо включать в поисковую выдачу именно новый адрес.

Если контент страницы не менялся с последнего посещения страницы роботом, лучше всего возвращать код HTTP-304. Робот поймет, что обновлять в результатах поиска страницы не нужно и передача контента тоже не будет происходить.

При кратковременной доступности вашего сайта, например, при проведении каких-либо работ на сервере, лучше всего настраивать HTTP-503. Он укажет роботу на то, что сейчас сайт и сервер недоступны, нужно зайти немножко попозже. При кратковременной недоступности это позволит предотвратить исключение страниц из поисковой выдачи.

Помимо этих HTTP-кодов, статусов страниц, необходимо еще получить непосредственно контент самой страницы. Если для обычного посетителя страница выглядит следующим образом:

это картиночки, текст, навигация, все очень красиво, то для индексирующего робота любая страница – это просто набор исходного кода, HTML-кода:

Различные метатеги, текстовое содержимое, ссылки, скрипты, куча всякой информации. Робот собирает ее и включает в поисковую выдачу. Кажется, все просто, запросили страницу – получили статус, получили содержимое, включили в поиск.

Но недаром в службу поискового сервиса в Яндексе приходит более 500 писем от вебмастеров и владельцев сайтов о том, что возникли определенные проблемы как раз с ответом сервера.

Все эти проблемы можно разделить на две части:

Это проблемы с HTTP-кодом ответа и проблемы с HTML-кодом, с непосредственным содержимым страниц. Причин возникновения этих проблем может быть огромное множество. Самая распространенная – это блокировка индексирующего робота хостинг-провайдером.

Например, вы запустили сайт, добавили новый раздел. Робот начинает посещать ваш сайт чаще, увеличивает нагрузку на сервер. Хостинг-провайдер видит это на своих мониторингах, блокирует индексирующего робота, и поэтому робот не может получить доступ к вашему сайту. Вы заходите на ваш ресурс – все отлично, все работает, странички красивенькие, все открывается, все супер, робот при этом проиндексировать сайт не может. При временной недоступности сайта, например, если забыли оплатить доменное имя, сайт отключен на несколько дней. Робот приходит на сайт, он недоступен, при таких условиях он может пропасть из поисковой выдачи буквально через некоторое время.

Некорректные настройки CMS, например, при обновлении или переходе на другую CMS, при обновлении дизайна, так же могут послужить причиной того, что страницы вашего сайта могут пропасть из выдачи при некорректных настройках. Например, наличие запрещающего метатега в исходном коде страниц сайта, некорректная настройка атрибута canonical. Проверяйте, что после всех изменений, которые вы вносите на сайт, страницы доступны для робота.

В этом вам поможет инструмент в Яндекс. Вебмастере по проверке ответа сервера:

Можно посмотреть какие HTTP заголовки возвращает ваш сервер роботу, непосредственно содержимое страниц.

В разделе «индексирование» собрана статистика, где вы можете посмотреть какие страницы исключены, динамику изменения этих показателей, сделать различную сортировку и фильтрацию.

Так же, уже сегодня говорил об этом разделе, раздел «диагностика сайта». В случае, если ваш сайт стал недоступен для робота, вы получите соответствующее уведомление и рекомендации. Каким образом это можно исправить? Если таких проблем не возникло, сайт доступен, отвечает кодам-200, содержит корректный контент, то робот начинает в автоматическом режиме посещать все страницы, которые он узнает. Не всегда это приводит к нужным последствиям, поэтому деятельность робота можно определенным образом ограничить. Для этого существует файл robots.txt. О нем мы и поговорим в следующем разделе.

Robots.txt

Сам по себе файлик robots.txt – это небольшой текстовый документ, лежит он в корневой папке сайта и содержит строгие правила для индексирующего робота, которые нужно выполнять при обходе сайта. Преимущества файла robots.txt заключаются в том, что для его использования не нужно особых и специальных знаний.

Достаточно открыть Блокнот, ввести определенные правила по формату, а затем просто сохранить файл на сервере. В течении суток робот начинает использовать эти правила.

Если взять пример файла robots.txt простенького, вот он, как раз на следующем слайде:

Директива User-Agent:” показывает для каких роботов предназначается правило, разрешающие\запрещающие директивы и вспомогательные директивы Sitemap и Host. Немножко теории, хочется перейти к практике.

Несколько месяцев назад мне захотелось купить шагометр, поэтому я обратился к Яндекс. Маркету за помощью с выбором. Перешел с главной страницы Яндекс на Яндекс. Маркет и попал на главную страницу сервиса.

Внизу вы видите адрес страницы, на которую я перешел. К адресу самого сервиса еще добавился идентификатор меня, как пользователя на сайте.

Потом я перешел в раздел «каталог»

Выбрал нужный подраздел и настроил параметры сортировки, цену, фильтр, как сортировать, производителя.

Получил список товаров, и адрес страницы уже разросся.

Зашел на нужный товар, нажал на кнопочку «добавить в корзину» и продолжил оформление.

За время моего небольшого путешествия адреса страниц менялись определенным образом.

К ним добавлялись служебные параметры, которые идентифицировали меня, как пользователя, настраивали сортировку, указывали владельцу сайта откуда я перешел на ту или иную страницу сайта.

Такие страницы, служебные страницы, я думаю, что не очень будут интересны пользователям поисковой системы. Но если они будут доступны для индексирующего робота, в поиск они могут попасть, поскольку робот себя ведет, по сути, как пользователь.

Он переходит на одну страничку, видит ссылочку, на которую можно кликнуть, переходит на нее, загружает данные в базу робота свою и продолжает такой обход всего сайта. В эту же категорию таких адресов можно отнести и личные данные пользователей, например, такие, как информация о доставке, либо контактные данные пользователей.

Естественно, их лучше запрещать. Как раз для этого и поможет вам файл robots.txt. Вы можете сегодня вечером по окончанию Вебмастерской прийти на свой сайт, покликать, посмотреть какие страницы действительно доступны.

Для того, чтобы проверить robots.txt существует специальный инструмент в Вебмастере:

Можно загрузить, ввести адреса страниц, посмотреть доступны они для робота или нет.

Внести какие-то изменения, посмотреть, как отреагирует робот на эти изменения.

Ошибки при работе с robots.txt

Помимо такого положительного влияния – закрытие служебных страниц, robots.txt при неправильном обращении может сыграть злую шутку.

Во-первых, самая распространенная проблема при использовании robots.txt – это закрытие действительно нужных страниц сайта, те, которые должны находиться в поиске и показываться по запросам. Прежде чем вы вносите изменения в robots.txt, обязательно проверьте не участвует ли страница, которую вы хотите закрыть, не показывается ли по запросам в поиске. Возможно страница с каким-то параметрами находится в выдаче и к ней приходят посетители из поиска. Поэтому обязательно проверьте перед использованием и внесением изменений в robots.txt.

Во-вторых, если на вашем сайте используются кириллические адреса, в robots.txt их указать не получится в прямом виде, их обязательно нужно кодировать. Поскольку robots.txt является международным стандартным, им следуют все индексирующие роботы, их обязательно нужно будет закодировать. Кириллицу в явном виде указать не получится.

Третья по популярности проблема – это различные правила для разных роботов разных поисковых систем. Для одного индексирующего робота закрыли все индексирующие страницы, для второго не закрыли совсем ничего. В результате этого у вас в одной поисковой системе все хорошо, в поиске нужная страница, а в другой поисковой системе может быть трэш, различные мусорные страницы, еще что-то. Обязательно следите, если вы устанавливаете запрет, его нужно делать для всех индексирующих роботов.

Четвертая по популярности проблема – это использование директивы Crawl-delay, когда в этом нет необходимости. Данная директива позволяет повлиять на чистоту запросов со стороны индексирующего робота. Это практический пример, маленький сайт, разместили его на небольшом хостинге, все прекрасно. Добавили большой каталог, робот пришел, увидел кучу новых страниц, начинает чаще обращаться на сайт, увеличивает нагрузку, скачивает это и сайт становится недоступным. Устанавливаем директиву Crawl-delay, робот видит это, снижает нагрузку, все отлично, сайт работает, все прекрасно индексируется, находится в выдаче. Спустя какое-то время сайт разрастается еще больше, переносится на новый хостинг, который готов справляться с этими запросами, с большим количеством запросов, а директиву Crawl-delay забывают убрать. В результате чего робот понимает, что на вашем сайте появилось очень много страниц, но не может их проиндексировать просто из-за установленной директивы. Если вы когда-либо использовали директиву Crawl-delay, проверьте, что сейчас ее нет и что ваш сервис готов справиться с нагрузкой от индексирующего робота.

Помимо описанной функциональности файл robots.txt позволяет еще решить две очень важные задачи – избавиться от дублей на сайте и указать адрес главного зеркала. Об этом как раз мы и поговорим в следующем разделе.

Дубли

Под дублями мы понимаем несколько страниц одного и того же сайта, которые содержат абсолютно идентичный контент. Самый распространенный пример – это страницы со слешом и без слеша в конце адреса. Так же под дублем можно понимать один и тот же товар в различных категориях.

Например, роликовые коньки могут быть для девочек, для мальчиков, одна и та же модель может находиться в двух разделах одновременно. И, в-третьих, это страницы с незначащим параметром. Как в примере с Яндекс. Маркетом эта страничка «идентификатор сессии», такой параметр не меняет контент страницы в принципе.

Чтобы обнаружить дубли, посмотреть к каким страницам робот обращается, вы можете использовать Яндекс. Вебмастер.

Помимо статистики есть еще и адреса страниц, которые робот загрузил. Вы видите код и последнее обращение.

Неприятности, к которым приводят дубли

Чем же плохи дубли?

Во-первых, робот начинает обращаться к абсолютно идентичным страницам сайта, что создает дополнительную нагрузку не только на ваш сервер, но и влияет на обход сайта в целом. Робот начинает уделять внимание дублирующим страницам, а не тем страницам, которые нужно индексировать и включать в поисковую выдачу.

Вторая проблема – это то, что дублирующие страницы, если они доступны для робота, могут попасть в результаты поиска и конкурировать с основными страницами по запросам, что, естественно, может негативно повлиять на нахождение сайта по тем или иным запросам.

Как можно бороться с дублями?

Прежде всего я советую использовать “canonical” тег для того, чтобы указать роботу на главную, каноническую страницу, которая должна индексироваться и находиться в поиске по запросам.

Во втором случае можно использовать 301 серверный редирект, например, для ситуаций со слешом на конце адреса и без слеша. Установили перенаправление – дублей нет.

И в-третьем, как я уже говорил, это файл robots.txt. Можно использовать как запрещающие директивы, так и директиву Clean-param для того, чтобы избавиться от незначащих параметров.

Зеркала сайта

Вторая задача, которую позволяет решить robots.txt – это указать роботу на адрес главного зеркала.

Зеркала – это группа сайтов, которые абсолютно идентичны, как дубли, только различные два сайта. Вебмастера обычно с зеркалами сталкиваются в двух случаях – когда хотят переехать на новый домен, либо, когда для пользователя нужно сделать несколько адресов сайта доступными.

Например, вы знаете, что пользователи, когда набирают ваш адрес, адрес вашего сайта в адресной строке, часто делают одну и ту же ошибку – опечатываются, не тот символ ставят или еще что-то. Можно приобрести дополнительный домен для того, чтобы пользователям показывать не заглушку от хостинг-провайдера, а показывать тот сайт, на который они действительно хотели перейти.

Остановимся на первом пункте, потому что именно с ним чаще всего и возникают проблемы в работе с зеркалами.

Весь процесс переезда я советую осуществлять по следующей инструкции. Небольшая инструкция, которая позволит вам избежать различных проблем при переезде на новое доменное имя:

Во-первых, вам необходимо сделать сайты доступными для индексирующего робота и разместить на них абсолютно идентичный контент. Так же убедитесь, что о существовании сайтов роботу известно. Проще всего добавить их в Яндекс. Вебмастер и подтвердить на них права.

Во-вторых, с помощью директивы Host указывайте роботу на адрес главного зеркала – тот, который должен индексироваться и находиться в результатах поиска.

Ждем склейки и переноса всех показателей со старого сайта на новый.

После чего уже можно установить перенаправление со старого адреса на новый. Простенькая инструкция, если вы переезжаете, обязательно используйте ее. Надеюсь, проблем не возникнет с

переездом.

Но, естественно, при работе с зеркалами возникают ошибки.

Прежде всего самая главная проблема – это отсутствие явных указаний для индексирующего робота на адрес главного зеркала, тот адрес, который должен находиться в поиске. Проверьте на ваших сайтах, что в robots.txt у них указана директива хоста, и она ведет именно на тот адрес, который вы хотите видеть в поиске.

Вторая по популярности проблема – это использование перенаправления для того, чтобы сменить главного зеркала в уже имеющейся группе зеркал. Что происходит? Старый адрес, поскольку осуществляет перенаправление, роботом не индексируется, исключается из поисковой выдачи. При этом новый сайт в поиск не попадает, поскольку является неглавным зеркалом. Вы теряете трафик, теряете посетителей, я думаю, что это никому не нужно.

И третья проблема – это недоступность одного из зеркал при переезде. Самый распространенный пример в этой ситуации, когда скопировали контент сайта на новый адрес, а старый адрес просто отключили, не оплатили доменное имя и он стал недоступен. Естественно такие сайты склеены не будут, они обязательно должны быть доступны для индексирующего робота.

Полезные ссылки в работе:

- Больше полезной информации вы найдете в сервисе Яндекс.Помощь .

- Все инструменты, о которых я говорил и даже больше – есть бета-версия Яндекс.Вебмастера .

Ответы на вопросы

«Спасибо за доклад. Нужно ли в robots.txt закрывать индексацию CSS-файлов для робота или нет?».

На текущий момент мы не рекомендуем закрывать их. Да, CSS, JavaScript лучше оставить, потому что сейчас, мы работаем над тем, чтобы индексирующий робот начал распознавать и скрипты на вашем сайте, и стили, видеть, как посетитель из обычного браузера.

«Подскажите, а если url’ы адресов сайта будут одинаковые, у старого и у нового – это нормально?».

Да, ничего страшного. По сути, у вас просто обновление дизайна, добавление какого-то контента.

«На сайте есть категория и она состоит из нескольких страниц: слеш, page1, page2, до 10-ти, допустим. На всех страницах один текст категории, и он, получается, дублирующий. Будет ли этот текст являться дубликатом или нужно его как-то закрывать, новый индекс на вторых и далее страницах?».

Прежде всего, поскольку на первой странице пагинации, а на второй странице контент, в целом-то, отличаются, они дублями не будут. Но нужно рассчитывать, что вторая, третья и дальше страницы пагинации могут попасть в поиск и показывать по какому-либо релевантному запросу. Лучше в страницах пагинации я бы рекомендовал использовать атрибут canonical, в самом лучшем случае – на странице, на которой собраны все товары для того, чтобы робот не включал страницы пагинации в поиске. Люди очень часто используют canonical на первую страницу пагинации. Робот приходит на вторую страницу, видит товар, видит текст, страницы в поиск не включает и понимает за счет атрибута, что надо включать в поисковую выдачу именно первую страницу пагинации. Используйте canonical, а сам текст закрывать, думаю, что не нужно.

Источник (видео): Как настроить индексирование сайта - Александр Смирнов

Магомед Чербижев

Поделиться:Всем привет друзья!

Многие сеошники на различных форумах часто спрашивают, почему Яндекс не индексирует сайт. В данной статье я постараюсь подробно ответить на этот вопрос и напишу возможные причины, почему все-таки Яндексу так сильно не понравился ваш ресурс, что он не хочет его индексировать:smile:.

Итак, давайте перейдем сразу к делу.

1. Сайт очень молодой.

Если вы недавно и начали писать статьи, то можете не переживать, все с вашим проектом нормально. Яндекс очень долго индексирует молодые ресурсы, иногда приходиться ждать несколько месяцем, да-да, и такое бывает.

Если ваш сайт очень молодой, то вполне возможно, что Яндекс его еще не нашел в интернете. Но вы можете помочь ему это сделать. Сейчас есть очень много способов, которые позволяют ускорить индексацию блога. О них вы можете прочитать . Если проделаете все то, что там написано, то через неделю ваш сайт точно проиндексируется в Яндексе, а возможно и быстрее.

2. Санкции от поисковых систем.

Если сайт уже не молодой, и он был в индексе, но потом внезапно вылетел, то, скорее всего, Яндексу что-то не понравилось, и он наложил на него санкции. Этих санкций есть очень много, но самая популярная, это фильтр АГС. Некоторые спрашивают: «Почему Яндекс не индексирует сайт кроме главной страницы

?». Если в индексе только главная страница, то, скорее всего, сайт находиться под АГС. О том, как проверить блог на АГС и как вывести его оттуда, я писал .

Кроме АГС сайт также мог попасть в Бан — это когда с индекса вылетают все страницы.

3. Случайный запрет индексации.

Многие новички по ошибке могут запретить индексировать сайт. Для примера в файле robots.txt за запрет индексации отвечает такая сточка:

User-agent: *

Disallow: /

Если вы хотите, чтобы ваш ресурс нормально индексировался в поисковых системах, то этой строчки не должно быть в robots.txt.

Кроме этого есть и другие способы, с помощью которых можно случайно . Если у вас ресурс сделан на движке wordpress, то перейдите в «Панель управление» - «Настройки» - «Чтение» и проверьте, чтобы возле надписи «Рекомендовать поисковым машинам не индексировать сайт» не было чекбокса.

4. Ошибка сервера.

Иногда может быть такое, что поисковый робот заходит на сайт, а ему выдается 505 ошибка. Конечно он сразу же покинет этот сайт, и думаю, еще не скоро на него вернется:smile:.

Если вы заходите на свой блог и часто видите 505 ошибку, то это очень плохо, советую сменить хостинг. Есть также и много других ошибок (500, 302) и т. д. Но думаю, вам не стоит забывать этим голову. Просто, проверьте, ответ сервера, он должен быть 200 ок . Проверить можно на этой странице :

5. Плохая история домена.

Если вы зарегистрировали новый домен и не проверили его историю, то это очень плохо. Может быть такое, что на этом домене был когда-то давно гавносайт и поисковые системы его забанили. Даже если вы теперь создали другой белый и пушистый ресурс, поисковики знаю историю, и поэтому могут его не индексировать. Я недавно писал статью о том, . Можете воспользоваться этой инструкцией.

6. Неуникальный контент.

Если на молодой сайт начать опубликовывать неуникальные статьи, то это очень плохо, поисковые системы могут перестать его индексировать или индексировать хуже.

Некоторые вебмастера считаю, что ничего страшного не произойдет, если статьи на других сайтах, главное чтобы посетителям нравилось. Но я думаю, что это так считаю только те люди, которым лень писать. Ведь, так намного проще, нашел, скопировал, вставил:smile:. За день можно опубликовать 100 статей, а через несколько лет уже будет целая википедия.

В общем, не слушайте никого, кто говорит, что можно копировать чужие статьи. Если вы хотите до большой посещаемости и зарабатывать потом на сайте деньги, то нужно писать статьи самостоятельно или заказывать у , но обязательно .

Форумы вебмастеров пестрят грустными постами по поводу того, что сайт плохо индексируется поисковыми системами. А ведь это основа SEO-продвижения, без которой популяризация интернет-ресурса практически невозможна.

Обидней всего, когда над созданием web-проекта трудился дорогостоящий программист, а на его наполнение контентом ежемесячно тратится внушительная сумма.

Однако Яндекс и Гугл не спешат индексировать отдельные страницы или даже целый сайт. Почему так происходит?

На этот вопрос нет однозначного ответа: существует множество причин.

Важно выявить конкретную проблему (технические ошибки, дубляж страниц, нестабильную работу хостинга или санкции поисковиков) и сделать все для ее решения. Есть хорошая новость - ситуацию можно исправить. Хотите, знать как? Читайте дальше!

Нормы индексации сайтов

В Яндекс

Yandex сканирует и добавляет новые страницы примерно два-четыре раза в месяц. Попасть в поисковую выдачу раньше способны лишь трастовые и часто обновляемые порталы - внушающие доверие сайты индексируются быстроботом Яндекса ежедневно.

В Google

Что касается Гугла, обновления могут занять от одного дня до двух недель. Здесь многое зависит от категории вашего сайта. Например, ресурсы с актуальными новостями и живые форумы роботы проверяют с завидной регулярностью.

Материалы часто обновляемых порталов обычно сканируются в тот же день или на следующий. Индексация блога, в котором каждую неделю появляется новый контент, нередко задерживается на 2–4 дня.

Совсем печально обстоит дело с третьесортными сайтами, а также совсем молодыми веб-проектами, только что появившимися в Сети. Поисковые роботы могут игнорировать их в течение месяца.

Важно! Вышеописанные данные актуальны при добавлении малого количества страниц в индекс. При добавлении большого количества страниц одномоментно, скорость индексации может увеличиться в несколько раз.

Особенно долго будут индексироваться страницы с малой ценностью для посетителей.

Что делать, если новый сайт не индексируется поисковиками?

Под это определение подходит ресурс с возрастом домена до полугода, который не имеет обратных ссылок и ранее не продвигался.

Добавить сайт в панели вебмастеров

Вы только что создали сайт и ждете чуда под названием «быстрая индексация»? Такая стратегия ошибочная, ведь в первое время Гугл и Яндекс не обращают на новый сайт внимание. Помогите своему проекту заинтересовать роботов - сделать это достаточно просто: надо лишь .

Важно! Использование сервиса Яндекс. Вебмастер и Google Webmaster не только ускорит добавление страниц в индекс, но и позволит эффективнее работать над оптимизацией сайта. Представленные инструменты бесплатно открывают вебмастерам множество возможностей для диагностики, получения рекомендованных для продвижения запросов и привязки сайта к конкретному региону.

Улучшить сайт

Пора заняться внутренней оптимизацией: систематически создавать первоклассный контент, улучшить юзабилити, сделав удобные рубрики, а также позаботиться об адаптивности и перелинковке. После этого следует задуматься о внешнем продвижении. Оно включает в себя работу с социальными факторами и размещение естественных ссылок у надежных доноров.

Если сайт все так же не индексируется Яндексом, необходимо написать в техническую поддержку поисковика. В результате вашего запроса вы получите информацию о наличии бана, фильтра или установите другую объективную причину возникшей проблемы.

Как проверить индексацию сайта?

Используйте в запросе оператор Site

Узнайте количество просканированных и добавленных в индекс страниц путем введения в строку поиска Гугл и Яндекс «site: url вашего сайта». Благодаря дополнительным настройкам легко получить данные о произошедших за конкретный промежуток времени изменения.

К примеру, сегодняшняя проверка российской версии Википедии показала, что за последние 2 недели на этом сайте появилось 143 новых материалов.

Учтите! Разница между показателями разных поисковых систем является поводом для тревоги. Чаще всего это свидетельствует о возможном попадании под фильтр Гугла или Яндекса.

Введите в поисковик url страницы

Этот способ идеален для проверки индексации отдельно выбранной страницы.

Для Google

url:https://ru.wikipedia.org/

Для Яндекс

info:https://ru.wikipedia.org/

Через панель вебмастеров

Если вы ранее уже зарегистрировались в Яндекс. Вебмастер, то при переходе на данный сервис сразу увидите число загруженных материалов и тех, что находятся в поиске. В идеале их количество должно совпадать или быть похожим на реальное количество страниц сайта.

Более детальную информацию вы получите при переходе на основную панель, после чего необходимо нажать «Индексирование» и «Страницы в поиске».

Анализируя полученный отчет и ищите страницы, которые не индексируются.

Вариант 2: Сайт вообще не индексируется в Яндексе и Гугле, страницы выпадают из индекса.

Код ответа сервера

Убедитесь, что страница содержит код сервера 200 ОК - это означает: она действительно существует, доступна к просмотру для пользователей и поисковых систем.

Проверка осуществляется при помощи специальных сервисов.

Например, http://www.bertal.ru/index.php?a1910327/

Если код ответа не 200 ОК, то именно в этом может быть причина не индексации страницы.

Robots.txt

В файле robots.txt недопустимы запреты на индексацию сайта и отдельных страниц, а также работу конкретного поисковика.

Важно! Обязательно проверьте сформированный robots.txt на ошибки. Сделать это можно в Google Вебмастер: нажмите на «Сканирование», а затем на «Инструмент проверки файла robots.txt».

Meta Robots

Часто сайт не индексируется в Гугле, если добавление сведений в базу данных запрещено в мета-тегах. Обязательно удалите в HTML-коде строкии если они есть на важных страницах.

Либо используйте плагины для браузера, такие как .

Rel Canonical

Хотите, чтобы страница попала в индекс поисковика? Тогда она не должна ссылаться на другой канонический документ.

Чтобы проверить откройте код страницы и сделайте поиск строки.

Либо через тот же плагин

Вебмастера

Используйте Google Webmaster Tools для выявления ошибок сканирования, из-за которых роботы не получают ответы на запросы.

Когда получите результат, сравните, что видит Google и пользователь. Картинки должны быть одинаковыми. Если нет, то ищите причины блокировки файлов.

Протестируйте скорость загрузки и время ответа сервера. Убедитесь, что выбранный вами хостинг работает стабильно.

Файл.htaccess

Если сайт не индексируется, он может быть заблокирован в файле.htaccess.

Проверьте.htaccess на наличие таких строк:

RewriteRule.* - [F]

Либо такой вариант, который будет отдавать роботу Google 404 ошибки.

RewriteCond %{USER_AGENT} Googlebot

RewriteRule.* -

Поищите в файле другие варианты блокировок с использованием USER_AGENT или названия поисковых ботов: googlebot, yandex и т. д.

AJAX и JavaScript

Распространены проблемы с языками AJAX и JavaScript. Блог Яндекса для вебмастеров рекомендует создать в структуре ресурса определенную схему , которая сообщит поисковым системам о необходимости индексации.

Санкции

Еще одна серьезная проблема - наложение санкций на страницу или даже весь сайт. Узнайте в техподдержке поисковой системы (только Яндекс), за что именно (ссылки, переспам, неуникальный контент) вас наказали, после чего оперативно исправьте ситуацию.

Как уже говорилось ранее, причиной отсутствия внимания к странице часто является низкокачественный и дублированный контент.

Вряд ли робот будет заинтересован в ваших материалах, если в выдаче уже имеются похожие документы, продвигаемые по тому же семантическому ядру.

Негативно влияет на скорость индексирования незрелый возраст домена, а также забаненный ранее б/у домен. В таком случае стоит написать запрос на пересмотр в Яндекс.

Итоги

Если сайт не индексируется Яндексом или Гуглом, значит, на то есть объективная причина. Ваша цель - выявить и решить проблему. Спустя некоторое время необходимо снова проверить индексацию страницы. Если вы все сделаете правильно, положительные изменения не заставят себя долго ждать!